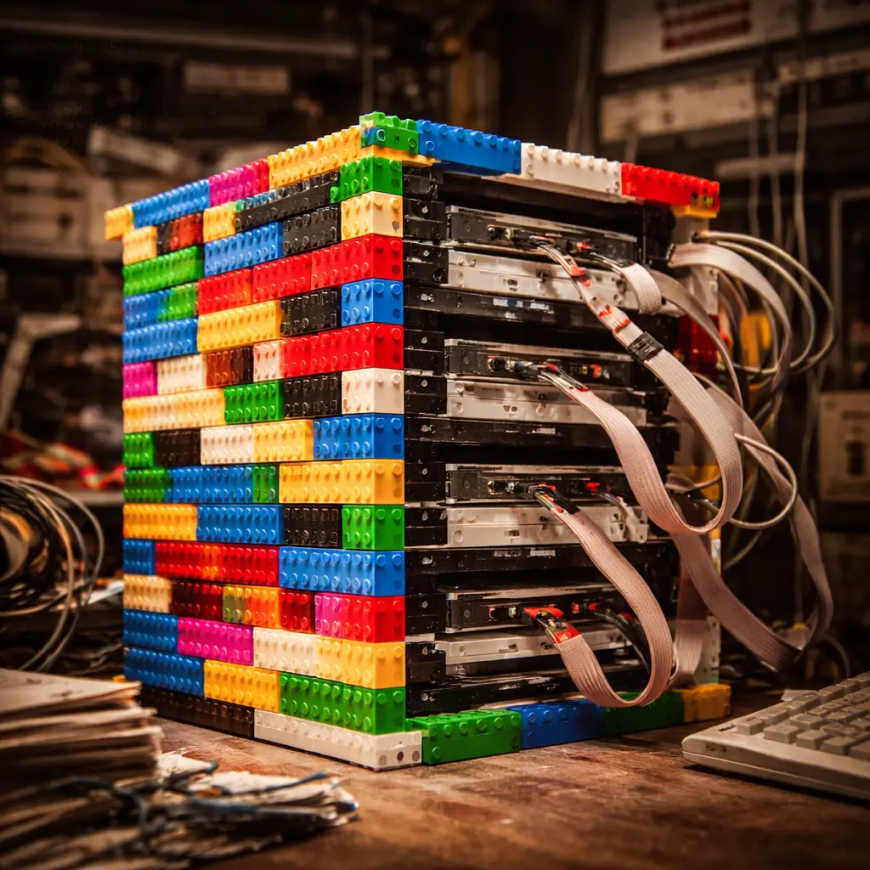

L'innovazione nasce dai mattoncini: perché il primo server di Google era fatto di LEGO

Nel 1996, un server da 40 GB ospitato in un case di LEGO ha cambiato per sempre il concetto di data center. Analizziamo come quella scelta economica e modulare abbia gettato le basi del cloud computing moderno e della filosofia hardware che utilizziamo ancora oggi.

Un case colorato per una rivoluzione digitale

Quando pensiamo ai data center moderni, immaginiamo corridoi asettici, luci LED blu e armadi rack metallici standardizzati che ronzano in ambienti a temperatura controllata. Eppure, la genesi di tutto ciò che oggi diamo per scontato nella ricerca online e nell'archiviazione dati risiede in una struttura molto più umile, assemblata con pazienza e mattoncini colorati. Nel nostro lavoro quotidiano in GoBooksy, dove gestiamo flussi di dati complessi e infrastrutture critiche, guardiamo spesso al passato per comprendere l'evoluzione dell'efficienza, e il primo server di Google rappresenta un caso studio perfetto di ingegneria pragmatica.

Nel 1996, Larry Page e Sergey Brin si trovavano a Stanford con un problema molto concreto e un budget estremamente limitato. Il loro algoritmo, BackRub (che sarebbe poi diventato Google), necessitava di uno spazio di archiviazione che per l'epoca era mostruoso: 40 gigabyte. Per ottenere quella capacità, dovettero combinare dieci dischi rigidi da 4 gigabyte ciascuno. Il problema non era solo elettronico, ma fisico. Non esistevano case per computer a basso costo capaci di ospitare dieci unità disco contemporaneamente in modo sicuro e accessibile. La soluzione non arrivò da un fornitore di hardware enterprise, ma da una scatola di LEGO Duplo.

La logica ingegneristica dietro il giocattolo

La scelta dei mattoncini non fu un vezzo estetico o una bizzarria da studenti eccentrici, ma una risposta tecnica brillante a vincoli reali. Costruire il case con i LEGO permise ai fondatori di Google di creare un'architettura perfettamente modulare ed espandibile a costo quasi zero. Questa flessibilità è un concetto che applichiamo costantemente anche nelle nostre architetture software odierne: la capacità di scalare e modificare la struttura portante senza dover abbattere e ricostruire l'intero sistema.

I mattoncini permisero di distanziare i dischi rigidi in modo ottimale per la dissipazione del calore, un problema che ancora oggi affligge chi progetta server farm ad alta densità. La plastica, pur essendo un isolante, nella configurazione aperta creata da Page e Brin, favoriva un flusso d'aria che i case metallici chiusi ed economici dell'epoca non potevano garantire. Osservando quella struttura primordiale, riconosciamo il principio fondante del "rapid prototyping": costruire, testare, fallire, modificare e riprovare con materiali immediatamente disponibili. In GoBooksy spesso ci troviamo a dover assemblare soluzioni temporanee per testare flussi di traffico o nuove configurazioni cloud, e lo spirito di adattamento di quel primo server rimane una lezione fondamentale su come la funzione debba sempre prevalere sulla forma.

La nascita del Commodity Hardware

Quello strano assemblaggio colorato nascondeva una rivoluzione filosofica che ha distrutto il mercato dei mainframe tradizionali. Fino a quel momento, le grandi aziende si affidavano a server monolitici costosissimi prodotti da giganti come IBM o Sun Microsystems. L'approccio di Google, simboleggiato dai LEGO, fu opposto: utilizzare hardware di consumo ("commodity hardware"), economico e facilmente reperibile, e affidare al software il compito di gestire i fallimenti.

Se un disco si rompeva, non serviva un tecnico specializzato per riparare un sistema proprietario complesso; bastava staccare il pezzo e sostituirlo, proprio come un mattoncino. Questa è la base su cui poggia l'intero ecosistema cloud moderno che utilizziamo per i nostri clienti. La ridondanza non è più garantita dalla perfezione del singolo componente hardware, ma dalla resilienza del sistema distribuito. Quel server da 40 GB ha dimostrato che una "batteria" di macchine economiche e imperfette, se orchestrata correttamente, è superiore a un singolo supercomputer perfetto.

Dalla stanza del dormitorio al cloud globale

Oggi, l'eredità di quel server si riflette nella gestione dei big data e nella virtualizzazione. La necessità di ospitare enormi quantità di informazioni con risorse limitate ha spinto l'industria verso la containerizzazione e l'orchestrazione delle risorse, concetti che sono il pane quotidiano per chi, come noi, sviluppa infrastrutture digitali. Non costruiamo più case con i mattoncini, ma costruiamo infrastrutture software che mantengono quella stessa modularità: microservizi che possono essere aggiunti, tolti o spostati senza che l'intero ecosistema crolli.

È affascinante notare come, nonostante la tecnologia abbia fatto passi da gigante in termini di potenza computazionale, le sfide rimangano le stesse: gestione del calore, ottimizzazione dello spazio, riduzione dei costi e scalabilità. Il primo server Google ci ricorda che l'innovazione non richiede necessariamente budget illimitati o tecnologie futuristiche inarrivabili. Spesso, la soluzione più efficace risiede nella capacità di guardare oggetti comuni e problemi complessi da una prospettiva laterale, trasformando un limite economico in un vantaggio strutturale. La vera potenza di calcolo non risiede nel silicio, ma nell'architettura che lo governa.