Quand les données pesaient une tonne : l'héritage physique du premier disque dur

Un voyage dans la matérialité de l'informatique de 1956, où stocker 5 Mégaoctets signifiait déplacer une machine industrielle de plus de mille kilogrammes. Nous analysons comment la densité magnétique et la mécanique lourde ont donné naissance au concept d'accès aléatoire aux données.

Dans notre travail quotidien chez GoBooksy, nous nous trouvons souvent à gérer des infrastructures cloud où des téraoctets d'informations circulent sans occuper le moindre espace physique visible, se déplaçant d'un continent à l'autre en quelques millisecondes. Cette dématérialisation est devenue si naturelle que nous avons presque oublié comment, à l'aube de l'ère numérique, le concept de "donnée" était intrinsèquement lié à une masse physique imposante et difficile à gérer. Pour comprendre vraiment l'évolution technologique qui nous a menés aux mémoires à semi-conducteurs actuelles, nous devons retourner en 1956 et observer de près un géant industriel qui a changé à jamais la façon de conserver la connaissance : l'IBM 350.

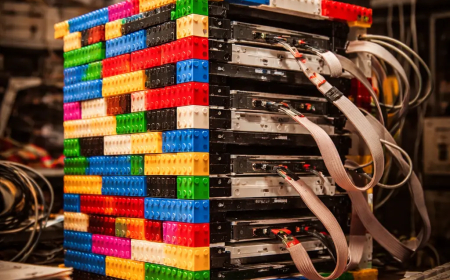

Quand on nous demande combien pesait le premier disque dur de l'histoire, la réponse laisse souvent incrédules les interlocuteurs habitués aux cartes microSD. Le premier véritable disque dur commercial, partie intégrante du système IBM 305 RAMAC (Random Access Method of Accounting and Control), pesait plus d'une tonne, soit environ 1 000 kilogrammes pour être précis. Il ne s'agissait pas d'un périphérique à poser sur un bureau, mais d'une armoire métallique imposante, large d'un mètre cinquante et haute de près d'un mètre quatre-vingts, qui nécessitait des chariots élévateurs et des sols renforcés pour être installée. La logistique derrière la livraison de ces premiers systèmes était une prouesse d'ingénierie en soi, à tel point qu'il était souvent nécessaire de démonter des fenêtres ou d'utiliser des avions-cargos spécifiques pour le transport vers les entreprises qui pouvaient se permettre le loyer mensuel, équivalent à l'époque au prix de plusieurs automobiles.

La raison d'une telle stature résidait dans la technologie mécanique nécessaire pour garantir ce que nous considérons aujourd'hui comme acquis : l'accès aléatoire aux données. Avant ce monstre sacré, le stockage se faisait principalement sur des bandes magnétiques ou des cartes perforées, qui obligeaient à une lecture séquentielle et lente. L'IBM 350 changea les règles du jeu en introduisant une pile verticale de cinquante disques magnétiques en aluminium, chacun d'un diamètre de 24 pouces, environ 61 centimètres. Ces disques, recouverts d'une peinture magnétique à l'oxyde de fer, tournaient à 1 200 tours par minute sur un seul arbre moteur. Imaginer cinquante "pizzas" métalliques géantes tournant de manière vertigineuse aide à comprendre pourquoi toute la structure devait être si massive et stable : les vibrations devaient être réduites au strict minimum pour permettre aux têtes de lecture d'opérer sans détruire la surface magnétique.

L'aspect peut-être le plus bouleversant, vu avec les yeux d'aujourd'hui, est le rapport entre ce poids titanesque et la capacité de stockage effective. Cette tonne de métal, de câbles, de moteurs et de circuits à tubes à vide était capable de mémoriser à peine 5 Mégaoctets de données. Pour donner une idée en termes modernes, la machine entière n'aurait pas suffi à contenir une seule photographie prise avec un smartphone de milieu de gamme ou un fichier MP3 de haute qualité. À l'époque, cependant, la possibilité d'archiver environ cinq millions de caractères alphanumériques et de pouvoir y accéder en moins d'une seconde représentait une révolution sans précédent pour la comptabilité d'entreprise et la gestion des stocks en temps réel.

Chez GoBooksy, nous réfléchissons souvent à la façon dont la densité surfacique, c'est-à-dire la quantité de bits qui peuvent être entassés dans un pouce carré, est le véritable paramètre qui a guidé l'évolution informatique. En 1956, la densité était d'à peine 2 000 bits par pouce carré. La tête de lecture et d'écriture était un chef-d'œuvre de mécanique pneumatique qui utilisait l'air comprimé pour "flotter" à une distance microscopique de la surface du disque, évitant le frottement qui aurait effacé les données. Ce mécanisme de coussin d'air est le précurseur direct de la technologie que, bien que raffinée à l'extrême, nous retrouvons encore dans les disques durs mécaniques modernes présents dans les centres de données.

Les défis auxquels faisaient face les ingénieurs du milieu du XXe siècle n'étaient pas si différents de ceux que nous gérons aujourd'hui dans la conception d'architectures serveurs, bien que l'échelle ait radicalement changé. La chaleur générée par les moteurs et les tubes de l'IBM 350 nécessitait des systèmes de refroidissement dédiés, tout comme les fermes de serveurs modernes nécessitent une climatisation avancée. La différence substantielle est qu'aujourd'hui nous concentrons des pétaoctets dans quelques racks, alors qu'à l'époque un centre de calcul entier avait moins de mémoire que le cache du processeur d'un ordinateur portable bon marché.

Retracer l'histoire de ce géant d'une tonne nous sert à garder la bonne perspective sur la valeur de l'optimisation. Chaque fois que nous travaillons sur le code pour économiser quelques kilooctets ou que nous optimisons une image pour le web, nous honorons un chemin commencé lorsque chaque octet individuel avait un coût physique et économique exorbitant. Le premier disque dur nous enseigne que l'innovation n'est pas seulement la miniaturisation, mais c'est surtout la capacité de rendre accessible et gérable ce qui était auparavant lent et séquentiel. La lourdeur du passé a été le fondement nécessaire pour la légèreté du présent numérique.