Combien de données créons-nous ?

Nous analysons la croissance vertigineuse des volumes de données mondiaux, en explorant ce que signifie réellement générer 2,5 quintillions d'octets par jour. Une plongée dans les infrastructures, les coûts cachés et la gestion critique de l'information à l'ère de l'hyper-production numérique.

Lorsque nous observons les moniteurs de nos centres de contrôle chez GoBooksy, nous ne voyons pas simplement des chiffres défiler, mais un flux ininterrompu d'activité humaine et mécanique qui se traduit en poids numérique. Le chiffre souvent cité de 2,5 quintillions d'octets générés chaque jour est difficile à visualiser pour l'esprit humain, mais pour nous qui gérons des infrastructures, ce nombre a une consistance physique très précise. Il signifie chaleur dissipée par les serveurs, demande énergétique croissante et nécessité continue d'étendre des espaces de stockage qui se remplissent à une vitesse sans précédent dans l'histoire de la technologie.

La donnée la plus bouleversante n'est pas tant le volume actuel, mais la rapidité avec laquelle nous y sommes parvenus. Savoir que 90 % de toutes les données existant dans le monde aujourd'hui ont été créées seulement au cours des deux dernières années nous oblige à revoir complètement notre approche de la conception des systèmes. Nous n'assistons pas à une croissance linéaire, mais à une explosion exponentielle qui rend obsolètes les vieux paradigmes de conservation. Dans nos projets quotidiens, nous remarquons comment la planification du stockage, qui se faisait autrefois sur une base annuelle, nécessite désormais une flexibilité quasi mensuelle pour ne pas risquer l'effondrement des ressources disponibles.

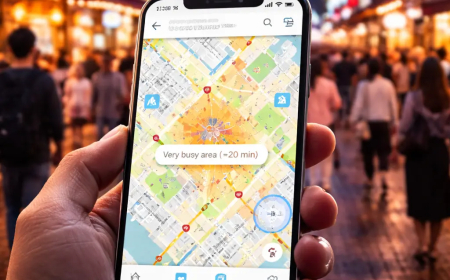

On commet souvent l'erreur de penser que cette masse de données provient exclusivement des actions conscientes des utilisateurs, comme l'envoi d'e-mails, le chargement de vidéos en 4K ou les interactions sur les réseaux sociaux. La réalité opérationnelle que nous affrontons chez GoBooksy nous raconte une histoire différente. Une portion énorme de ces quintillions d'octets est générée par les machines qui parlent à d'autres machines. Les capteurs IoT industriels, les journaux système qui enregistrent chaque micro-événement sur un serveur, les sauvegardes automatisées et les métadonnées cachées derrière chaque fichier constituent un "bruit de fond" assourdissant et volumineux. Ce trafic invisible est essentiel au fonctionnement du réseau moderne, mais il occupe de l'espace réel sur des disques réels, posant des défis énormes en termes d'indexation et de récupération des informations.

La conséquence directe de cette hyper-production est le phénomène que nous observons de plus en plus souvent dans les entreprises avec lesquelles nous collaborons : l'accumulation de "Dark Data". Il s'agit d'informations qui sont collectées, traitées et archivées, mais qui ne seront plus jamais utilisées à des fins stratégiques ou décisionnelles. Maintenir ces données en vie a un coût économique et environnemental élevé. Nous voyons des infrastructures ralenties par des téraoctets de fichiers dupliqués ou obsolètes, qui compliquent les opérations de sauvegarde et rendent les systèmes moins réactifs. Le défi actuel n'est plus de savoir comment tout stocker, mais de comprendre ce qui a de la valeur et ce qui peut être abandonné.

L'impact de cette accélération se reflète également sur la sécurité et la confidentialité. Plus on crée de données, plus la surface d'attaque s'élargit et plus la gestion de la conformité devient complexe. Chaque octet généré porte avec lui une responsabilité de protection. Dans les flux de travail que nous structurons chez GoBooksy, l'attention s'est déplacée de la simple capacité d'accumulation vers l'intelligence dans la gestion du cycle de vie de la donnée. Il ne suffit pas d'avoir un espace infini dans le cloud ; il faut la capacité de gouverner l'information, en distinguant le signal utile du bruit de fond qui engorge les autoroutes numériques.

Nous devons commencer à considérer la production de données non pas comme une ressource infinie et gratuite, mais comme une matière qui a un poids spécifique. La facilité avec laquelle nous créons des contenus numériques nous a déshabitués à réfléchir à leur impact à long terme. Chaque fois qu'un système automatisé enregistre une version d'un fichier ou qu'un utilisateur synchronise un appareil, une chaîne de processus physiques et énergétiques complexes s'active. Comprendre l'échelle réelle de ces 2,5 quintillions d'octets quotidiens est la première étape pour passer d'une culture de l'accumulation indiscriminée à une stratégie d'efficacité numérique, où la qualité de l'information prévaut enfin sur sa quantité démesurée.