CAPTCHA, c'est nous : Le paradoxe du travail invisible derrière la vérification humaine

Nous analysons comment les systèmes de vérification ne servent pas seulement la sécurité, mais transforment les utilisateurs en main-d'œuvre pour l'entraînement des intelligences artificielles. Une exploration de l'équilibre délicat entre protection des données, expérience utilisateur et la valeur non déclarée de nos interactions numériques.

CAPTCHA, c'est nous

Chaque jour, des millions de fois par jour, le flux numérique mondial s'interrompt pendant une fraction de seconde. Devant un écran de connexion ou un formulaire de contact, il nous est demandé d'identifier des feux de circulation, des passages piétons, des bouches d'incendie ou des vélos pixellisés. Ce que nous percevons comme une mesure de sécurité banale est en réalité l'une des plus grandes opérations de travail collectif distribué jamais réalisées. Chez GoBooksy, en travaillant quotidiennement sur l'architecture des flux de données et l'interaction utilisateur, nous observons constamment comment ce mécanisme n'est pas simplement une porte d'entrée, mais un échange de valeur souvent déséquilibré. Nous ne prouvons pas seulement que nous sommes humains ; nous prêtons notre capacité cognitive pour apprendre aux machines à voir le monde comme nous.

La réalité opérationnelle que nous rencontrons dans la gestion des infrastructures web nous montre que le concept classique du test de Turing a été complètement inversé. Initialement, ces tests servaient à numériser des livres que les systèmes de reconnaissance optique ne parvenaient pas à lire. Chaque fois qu'un utilisateur déchiffrait un mot déformé, il sauvait littéralement un morceau d'archive analogique. Aujourd'hui, la nature des images qui nous sont proposées a radicalement changé car les besoins des intelligences artificielles nécessitant un entraînement ont évolué. Lorsque nous sélectionnons toutes les cases contenant un bus, nous affinons les algorithmes de conduite autonome, enseignant aux véhicules à distinguer les obstacles urbains avec la précision que seul l'œil humain possède encore dans certaines conditions d'ambiguïté visuelle.

Cette dynamique introduit une friction notable dans l'expérience utilisateur, un problème que nous affrontons souvent lors de la conception d'interfaces pour nos clients. Il existe un point de rupture subtil mais tangible : lorsque la sécurité devient trop invasive, l'utilisateur abandonne la navigation. Nous avons remarqué que l'implémentation agressive de défis visuels réduit drastiquement les taux de conversion, créant de la frustration chez ceux qui cherchent simplement à accéder à un service légitime. Le paradoxe est que les bots, ces logiciels automatiques que ces systèmes devraient bloquer, sont devenus si sophistiqués qu'ils résolvent les puzzles visuels avec une vitesse et une précision souvent supérieures à celles des humains. Par conséquent, pour maintenir l'efficacité, les tests sont devenus progressivement plus difficiles pour les personnes réelles, allant jusqu'à proposer des images si confuses ou culturellement spécifiques qu'elles en deviennent incompréhensibles.

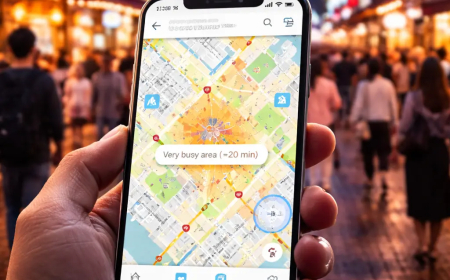

L'évolution technologique déplace heureusement l'axe vers une vérification invisible, basée non pas sur ce que l'utilisateur sait résoudre, mais sur son comportement. Dans les systèmes que nous surveillons et intégrons dans l'écosystème GoBooksy, nous privilégions de plus en plus l'analyse biométrique comportementale. Cette approche évalue le mouvement de la souris, l'accélération du curseur, les temps de réaction et même les micro-hésitations qui sont intrinsèquement humaines et extrêmement difficiles à reproduire pour un algorithme scripté. Nous ne demandons plus à l'utilisateur de travailler pour le système ; nous laissons le système comprendre la nature de l'utilisateur à travers l'analyse des modèles de navigation. Si cela améliore l'utilisabilité en éliminant les interruptions, cela ouvre également des questions profondes sur la vie privée et le traçage constant, car la vérification devient un processus continu et silencieux, et non plus un obstacle unique à surmonter.

Il reste fondamental de comprendre que la sécurité totale sur le web est une illusion, et la gestion du risque doit être équilibrée. Souvent, nous intervenons pour recalibrer des systèmes défensifs qui, dans la tentative d'exclure toute menace automatisée possible, finissent par exclure des segments d'utilisateurs légitimes, peut-être ceux qui utilisent des technologies d'assistance ou naviguent depuis des connexions partagées à réputation mixte. Le défi technique n'est pas d'ériger des murs plus hauts, mais de construire des filtres plus intelligents qui sachent distinguer l'intention malveillante du comportement humain authentique, même lorsque ce dernier est imparfait ou imprévisible.

L'avenir de la vérification de l'identité en ligne s'éloigne de la demande de preuves cognitives explicites pour se rapprocher d'un modèle de confiance réputationnelle. Dans ce scénario, GoBooksy continue d'observer et d'adapter ses technologies, conscient que chaque clic sur une image, ou chaque seconde d'hésitation de la souris, est une donnée précieuse. Nous sommes passés du statut de simples utilisateurs à celui, inconscient, de validateurs finaux de la réalité pour les machines que nous construisons. La prochaine fois que le système nous demandera de confirmer notre humanité, nous saurons qu'il ne contrôle pas seulement qui nous sommes, mais qu'il apprend de nous comment être un peu plus humain lui-même.