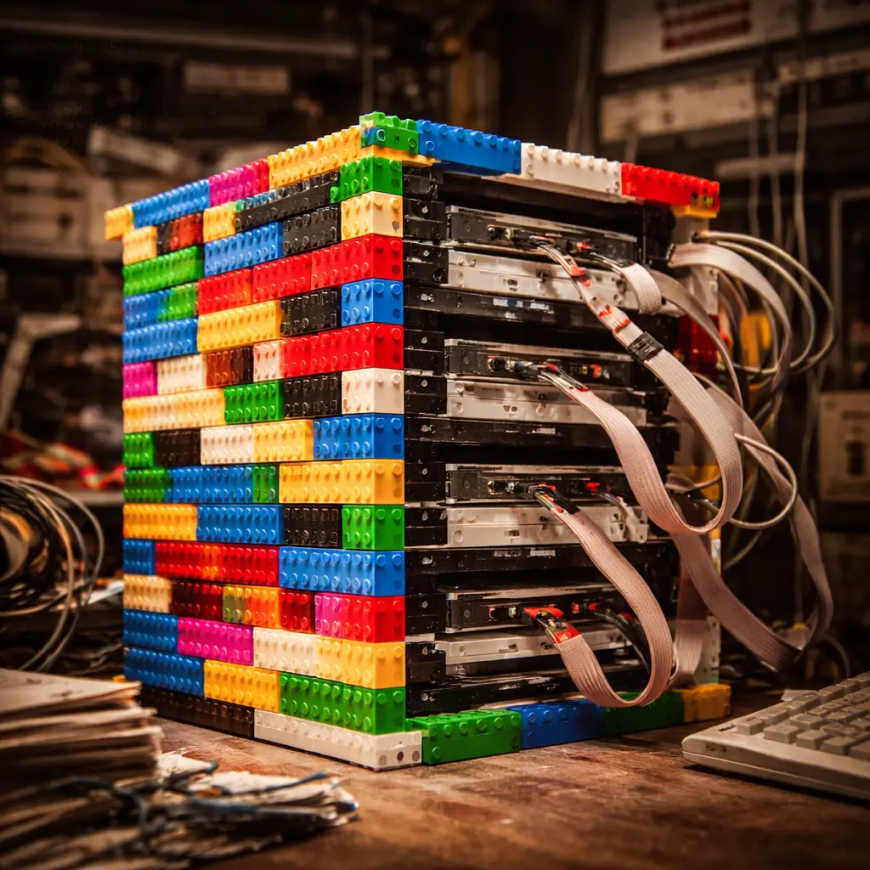

La innovación nace de los ladrillos: por qué el primer servidor de Google estaba hecho de LEGO

En 1996, un servidor de 40 GB alojado en una carcasa de LEGO cambió para siempre el concepto de centro de datos. Analizamos cómo esa elección económica y modular sentó las bases del cloud computing moderno y de la filosofía de hardware que utilizamos hoy.

Una carcasa colorida para una revolución digital

Cuando pensamos en los centros de datos modernos, imaginamos pasillos asépticos, luces LED azules y armarios rack metálicos estandarizados que zumban en ambientes con temperatura controlada. Sin embargo, la génesis de todo lo que hoy damos por sentado en la búsqueda online y en el almacenamiento de datos reside en una estructura mucho más humilde, ensamblada con paciencia y ladrillos de colores. En nuestro trabajo diario en GoBooksy, donde gestionamos flujos de datos complejos e infraestructuras críticas, miramos a menudo al pasado para comprender la evolución de la eficiencia, y el primer servidor de Google representa un caso de estudio perfecto de ingeniería pragmática.

En 1996, Larry Page y Sergey Brin se encontraban en Stanford con un problema muy concreto y un presupuesto extremadamente limitado. Su algoritmo, BackRub (que luego se convertiría en Google), necesitaba un espacio de almacenamiento que para la época era monstruoso: 40 gigabytes. Para obtener esa capacidad, tuvieron que combinar diez discos duros de 4 gigabytes cada uno. El problema no era solo electrónico, sino físico. No existían carcasas para ordenadores de bajo coste capaces de alojar diez unidades de disco simultáneamente de forma segura y accesible. La solución no llegó de un proveedor de hardware empresarial, sino de una caja de LEGO Duplo.

La lógica ingenieril detrás del juguete

La elección de los ladrillos no fue un capricho estético o una excentricidad de estudiantes, sino una respuesta técnica brillante a restricciones reales. Construir la carcasa con LEGO permitió a los fundadores de Google crear una arquitectura perfectamente modular y expandible a un coste casi nulo. Esta flexibilidad es un concepto que aplicamos constantemente también en nuestras arquitecturas de software actuales: la capacidad de escalar y modificar la estructura portante sin tener que demoler y reconstruir todo el sistema.

Los ladrillos permitieron distanciar los discos duros de manera óptima para la disipación del calor, un problema que todavía hoy aflige a quienes diseñan granjas de servidores de alta densidad. El plástico, aun siendo un aislante, en la configuración abierta creada por Page y Brin, favorecía un flujo de aire que las carcasas metálicas cerradas y económicas de la época no podían garantizar. Observando esa estructura primordial, reconocemos el principio fundante del "rapid prototyping": construir, probar, fallar, modificar y volver a intentar con materiales inmediatamente disponibles. En GoBooksy a menudo nos encontramos teniendo que ensamblar soluciones temporales para probar flujos de tráfico o nuevas configuraciones en la nube, y el espíritu de adaptación de ese primer servidor sigue siendo una lección fundamental sobre cómo la función debe prevalecer siempre sobre la forma.

El nacimiento del Commodity Hardware

Ese extraño ensamblaje colorido escondía una revolución filosófica que destruyó el mercado de los mainframes tradicionales. Hasta ese momento, las grandes empresas confiaban en servidores monolíticos carísimos producidos por gigantes como IBM o Sun Microsystems. El enfoque de Google, simbolizado por los LEGO, fue opuesto: utilizar hardware de consumo ("commodity hardware"), económico y fácil de conseguir, y confiar al software la tarea de gestionar los fallos.

Si un disco se rompía, no hacía falta un técnico especializado para reparar un sistema propietario complejo; bastaba con desconectar la pieza y sustituirla, tal como un ladrillo. Esta es la base sobre la que se apoya todo el ecosistema cloud moderno que utilizamos para nuestros clientes. La redundancia ya no está garantizada por la perfección del componente de hardware individual, sino por la resiliencia del sistema distribuido. Ese servidor de 40 GB demostró que una batería de máquinas económicas e imperfectas, si se orquesta correctamente, es superior a un único superordenador perfecto.

De la habitación del dormitorio a la nube global

Hoy, el legado de ese servidor se refleja en la gestión del big data y en la virtualización. La necesidad de alojar enormes cantidades de información con recursos limitados ha empujado a la industria hacia la contenedorización y la orquestación de recursos, conceptos que son el pan de cada día para quienes, como nosotros, desarrollamos infraestructuras digitales. Ya no construimos carcasas con ladrillos, pero construimos infraestructuras de software que mantienen esa misma modularidad: microservicios que pueden añadirse, quitarse o moverse sin que todo el ecosistema colapse.

Es fascinante notar cómo, a pesar de que la tecnología ha dado pasos agigantados en términos de potencia computacional, los desafíos siguen siendo los mismos: gestión del calor, optimización del espacio, reducción de costes y escalabilidad. El primer servidor de Google nos recuerda que la innovación no requiere necesariamente presupuestos ilimitados o tecnologías futuristas inalcanzables. A menudo, la solución más eficaz reside en la capacidad de mirar objetos comunes y problemas complejos desde una perspectiva lateral, transformando un límite económico en una ventaja estructural. La verdadera potencia de cálculo no reside en el silicio, sino en la arquitectura que lo gobierna.