Cuando los datos pesaban una tonelada: el legado físico del primer disco duro

Un viaje a la materialidad de la informática de 1956, cuando archivar 5 Megabytes significaba mover una maquinaria industrial de más de mil kilogramos. Analizamos cómo la densidad magnética y la mecánica pesada dieron origen al concepto de acceso aleatorio a los datos.

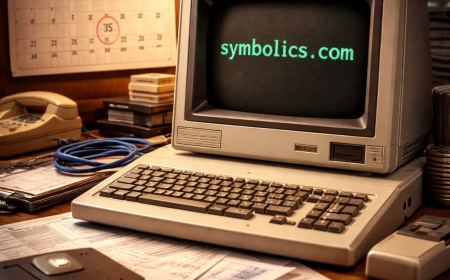

En nuestro trabajo diario en GoBooksy, nos encontramos a menudo gestionando infraestructuras en la nube donde terabytes de información fluyen sin ocupar espacio físico visible, desplazándose de un continente a otro en milisegundos. Esta desmaterialización se ha vuelto tan natural que casi hemos olvidado cómo, en el origen de la era digital, el concepto de "dato" estaba intrínsecamente ligado a una masa física imponente y difícil de gestionar. Para comprender verdaderamente la evolución tecnológica que nos ha llevado a las actuales memorias de estado sólido, debemos regresar a 1956 y observar de cerca a un gigante industrial que cambió para siempre la forma de conservar el conocimiento: el IBM 350.

Cuando nos preguntan cuánto pesaba el primer disco duro de la historia, la respuesta suele dejar incrédulos a los interlocutores acostumbrados a las tarjetas microSD. El primer verdadero disco rígido comercial, parte integral del sistema IBM 305 RAMAC (Random Access Method of Accounting and Control), pesaba más de una tonelada, concretamente unos 1.000 kilogramos. No se trataba de un periférico para colocar sobre el escritorio, sino de un armario metálico imponente, de un metro y medio de ancho y casi un metro ochenta de alto, que requiríera carretillas elevadoras y suelos reforzados para ser instalado. La logística detrás de la entrega de estos primeros sistemas era una hazaña de ingeniería en sí misma, tanto que a menudo era necesario desmontar ventanas o utilizar aviones de carga específicos para el transporte hacia las empresas que podían permitirse el alquiler mensual, equivalente en aquella época al precio de varios automóviles.

La razón de tal envergadura residía en la tecnología mecánica necesaria para garantizar lo que hoy damos por sentado: el acceso aleatorio a los datos. Antes de este monstruo sagrado, el almacenamiento se realizaba principalmente en cintas magnéticas o tarjetas perforadas, que obligaban a una lectura secuencial y lenta. El IBM 350 cambió las reglas del juego introduciendo una pila vertical de cincuenta discos magnéticos de aluminio, cada uno con un diámetro de 24 pulgadas, unos 61 centímetros. Estos discos, recubiertos de una pintura magnética de óxido de hierro, giraban a 1.200 revoluciones por minuto sobre un único eje motor. Imaginar cincuenta "pizzas" metálicas gigantes girando vertiginosamente ayuda a comprender por qué toda la estructura debía ser tan masiva y estable, ya que las vibraciones debían reducirse al mínimo absoluto para permitir que los cabezales de lectura operaran sin destruir la superficie magnética.

El aspecto quizás más impactante, si se mira con los ojos de hoy, es la relación entre este peso titánico y la capacidad de almacenamiento efectiva. Aquella tonelada de metal, cables, motores y circuitos de válvulas era capaz de memorizar apenas 5 Megabytes de datos. Para dar una idea en términos modernos, toda la maquinaria no habría sido suficiente para contener una sola fotografía tomada con un teléfono inteligente de gama media o un archivo MP3 de alta calidad. En aquella época, sin embargo, la posibilidad de archivar unos cinco millones de caracteres alfanuméricos y poder acceder a ellos en menos de un segundo representaba una revolución sin precedentes para la contabilidad empresarial y la gestión de inventarios en tiempo real.

En GoBooksy reflexionamos a menudo sobre cómo la densidad de área, es decir, la cantidad de bits que pueden acumularse en una pulgada cuadrada, es el verdadero parámetro que ha guiado la evolución informática. En 1956, la densidad era de apenas 2.000 bits por pulgada cuadrada. El cabezal de lectura y escritura era una obra maestra de mecánica neumática que utilizaba aire comprimido para "flotar" a una distancia microscópica de la superficie del disco, evitando la fricción que habría borrado los datos. Este mecanismo de cojinete de aire es el precursor directo de la tecnología que, aunque refinada al extremo, encontramos todavía en los modernos discos duros mecánicos presentes en los centros de datos.

Los desafíos que enfrentaban los ingenieros de mediados del siglo XX no eran tan diferentes de los que gestionamos hoy en el diseño de arquitecturas de servidores, aunque la escala haya cambiado drásticamente. El calor generado por los motores y las válvulas del IBM 350 requería sistemas de refrigeración dedicados, tal como las modernas granjas de servidores necesitan climatización avanzada. La diferencia sustancial es que hoy concentramos petabytes en unos pocos racks, mientras que entonces un centro de cálculo entero tenía menos memoria que la caché del procesador de un portátil económico.

Recorrer la historia de este gigante de una tonelada nos sirve para mantener la perspectiva correcta sobre el valor de la optimización. Cada vez que trabajamos en el código para ahorrar unos pocos kilobytes u optimizamos una imagen para la web, estamos honrando un camino iniciado cuando cada byte individual tenía un coste físico y económico exorbitante. El primer disco duro nos enseña que la innovación no es solo miniaturización, sino que es sobre todo la capacidad de hacer accesible y manejable lo que antes era lento y secuencial. La pesadez del pasado fue el fundamento necesario para la ligereza del presente digital.