Als Daten eine Tonne wogen: Das physische Erbe der ersten Festplatte

Eine Reise in die Materialität der Informatik von 1956, als das Speichern von 5 Megabyte bedeutete, eine über tausend Kilogramm schwere Industriemaschine zu bewegen. Wir analysieren, wie magnetische Dichte und schwere Mechanik das Konzept des direkten Datenzugriffs begründeten.

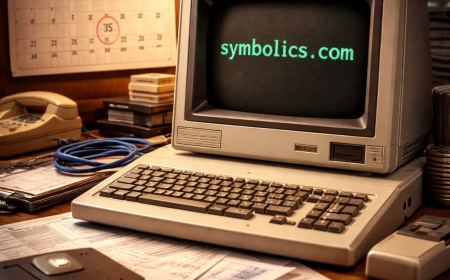

In unserer täglichen Arbeit bei GoBooksy verwalten wir oft Cloud-Infrastrukturen, in denen Terabytes an Informationen fließen, ohne sichtbaren physischen Raum einzunehmen, und sich in Millisekunden von einem Kontinent zum anderen bewegen. Diese Entmaterialisierung ist so natürlich geworden, dass wir fast vergessen haben, wie sehr das Konzept der "Daten" zu Beginn des digitalen Zeitalters untrennbar mit einer imposanten und schwer zu handhabenden physischen Masse verbunden war. Um die technologische Evolution, die uns zu den aktuellen Solid-State-Speichern geführt hat, wirklich zu verstehen, müssen wir ins Jahr 1956 zurückkehren und einen Industriegiganten genau betrachten, der die Art und Weise der Wissensbewahrung für immer verändert hat: den IBM 350.

Wenn wir gefragt werden, wie viel die erste Festplatte der Geschichte wog, lässt die Antwort Gesprächspartner, die an microSD-Karten gewöhnt sind, oft ungläubig zurück. Die erste echte kommerzielle Festplatte, integraler Bestandteil des Systems IBM 305 RAMAC (Random Access Method of Accounting and Control), wog über eine Tonne, genauer gesagt etwa 1.000 Kilogramm. Es handelte sich nicht um ein Peripheriegerät für den Schreibtisch, sondern um einen imposanten Metallschrank, anderthalb Meter breit und fast ein Meter achtzig hoch, dessen Installation Gabelstapler und verstärkte Böden erforderte. Die Logistik hinter der Auslieferung dieser ersten Systeme war eine ingenieurtechnische Meisterleistung für sich, so dass oft Fenster ausgebaut oder spezielle Frachtflugzeuge für den Transport zu jenen Unternehmen eingesetzt werden mussten, die sich die monatliche Miete leisten konnten, die damals dem Preis mehrerer Automobile entsprach.

Der Grund für diese Ausmaße lag in der mechanischen Technologie, die notwendig war, um das zu gewährleisten, was wir heute als selbstverständlich ansehen: den direkten Zugriff auf Daten. Vor diesem heiligen Monster erfolgte die Speicherung hauptsächlich auf Magnetbändern oder Lochkarten, was ein langsames und sequentielles Lesen erzwang. Der IBM 350 änderte die Spielregeln durch die Einführung eines vertikalen Stapels von fünfzig magnetischen Aluminiumscheiben mit einem Durchmesser von jeweils 24 Zoll, etwa 61 Zentimetern. Diese Scheiben, beschichtet mit einem magnetischen Eisenoxidlack, rotierten mit 1.200 Umdrehungen pro Minute auf einer einzigen Antriebswelle. Wenn man sich fünfzig riesige Metall-"Pizzas" vorstellt, die sich wirbelnd drehen, versteht man, warum die gesamte Struktur so massiv und stabil sein musste: Vibrationen mussten auf ein absolutes Minimum reduziert werden, damit die Leseköpfe arbeiten konnten, ohne die magnetische Oberfläche zu zerstören.

Der vielleicht schockierendste Aspekt aus heutiger Sicht ist das Verhältnis zwischen diesem titanischen Gewicht und der tatsächlichen Speicherkapazität. Diese Tonne aus Metall, Kabeln, Motoren und Röhrenschaltkreisen war in der Lage, gerade einmal 5 Megabyte an Daten zu speichern. Um dies in modernen Begriffen zu verdeutlichen: Die gesamte Maschine hätte nicht ausgereicht, um ein einziges Foto eines Mittelklasse-Smartphones oder eine hochwertige MP3-Datei zu fassen. Damals jedoch stellte die Möglichkeit, etwa fünf Millionen alphanumerische Zeichen zu archivieren und in weniger als einer Sekunde darauf zugreifen zu können, eine beispiellose Revolution für die Unternehmensbuchhaltung und die Echtzeit-Bestandsverwaltung dar.

Bei GoBooksy reflektieren wir oft darüber, wie die Speicherdichte, also die Menge an Bits, die auf einen Quadratzoll gepackt werden können, der wahre Parameter ist, der die Informatik-Evolution geleitet hat. 1956 betrug die Dichte gerade einmal 2.000 Bits pro Quadratzoll. Der Lese- und Schreibkopf war ein Meisterwerk der pneumatischen Mechanik, das Druckluft nutzte, um in mikroskopischem Abstand über der Diskettenoberfläche zu "schweben" und so die Reibung zu vermeiden, die die Daten gelöscht hätte. Dieser Luftpolstermechanismus ist der direkte Vorläufer der Technologie, die wir, wenn auch extrem verfeinert, noch heute in modernen mechanischen Festplatten in Rechenzentren finden.

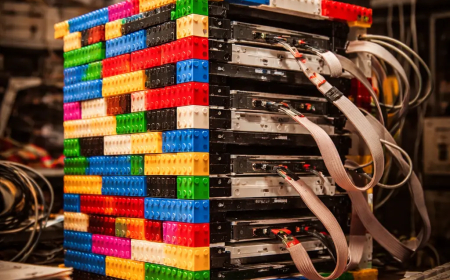

Die Herausforderungen, denen sich die Ingenieure Mitte des 20. Jahrhunderts stellten, unterschieden sich gar nicht so sehr von denen, die wir heute beim Entwurf von Serverarchitekturen bewältigen, auch wenn sich der Maßstab drastisch geändert hat. Die von den Motoren und Röhren des IBM 350 erzeugte Wärme erforderte dedizierte Kühlsysteme, genau wie moderne Serverfarmen eine fortschrittliche Klimatisierung benötigen. Der wesentliche Unterschied besteht darin, dass wir heute Petabytes in wenigen Racks konzentrieren, während damals ein ganzes Rechenzentrum weniger Speicher hatte als der Prozessor-Cache eines günstigen Laptops.

Die Geschichte dieses Ein-Tonnen-Riesen nachzuverfolgen hilft uns, die richtige Perspektive auf den Wert der Optimierung zu bewahren. Jedes Mal, wenn wir am Code arbeiten, um ein paar Kilobyte zu sparen, oder ein Bild für das Web optimieren, ehren wir einen Weg, der begann, als jedes einzelne Byte astronomische physische und wirtschaftliche Kosten verursachte. Die erste Festplatte lehrt uns, dass Innovation nicht nur Miniaturisierung ist, sondern vor allem die Fähigkeit, das zugänglich und handhabbar zu machen, was zuvor langsam und sequentiell war. Die Schwere der Vergangenheit war das notwendige Fundament für die Leichtigkeit der digitalen Gegenwart.