Quantos dados criamos?

Analisamos o crescimento vertiginoso dos volumes de dados globais, explorando o que significa realmente gerar 2,5 quintilhões de bytes por dia. Um aprofundamento sobre infraestruturas, custos ocultos e a gestão crítica da informação na era da hiperprodução digital.

Quando observamos os monitores dos nossos centros de controle na GoBooksy, não vemos simplesmente números correndo, mas um fluxo ininterrupto de atividade humana e mecânica que se traduz em peso digital. A cifra frequentemente citada de 2,5 quintilhões de bytes gerados a cada dia é difícil de visualizar para a mente humana, mas para nós que gerimos infraestruturas, este número tem uma consistência física muito precisa. Significa calor dissipado pelos servidores, demanda energética crescente e a necessidade contínua de expandir espaços de armazenamento que se enchem a uma velocidade sem precedentes na história da tecnologia.

O dado mais chocante não é tanto o volume atual, mas a rapidez com que chegamos aqui. Saber que 90% de todos os dados existentes no mundo hoje foram criados apenas nos últimos dois anos nos obriga a rever completamente nossa abordagem no design de sistemas. Não estamos assistindo a um crescimento linear, mas a uma explosão exponencial que torna obsoletos os velhos paradigmas de conservação. Em nossos projetos diários notamos como o planejamento de armazenamento, que antes era feito em base anual, agora requer uma flexibilidade quase mensal para não arriscar o colapso dos recursos disponíveis.

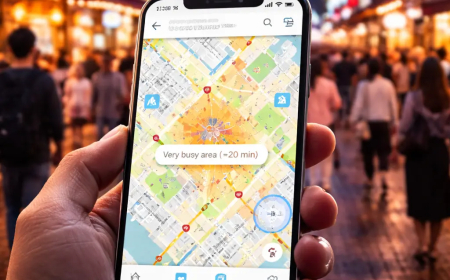

Muitas vezes comete-se o erro de pensar que essa mole de dados provém exclusivamente das ações conscientes dos usuários, como o envio de e-mails, o carregamento de vídeos em 4K ou as interações nas redes sociais. A realidade operacional que enfrentamos na GoBooksy nos conta uma história diferente. Uma porção enorme desses quintilhões de bytes é gerada pelas máquinas que falam com outras máquinas. Os sensores IoT industriais, os logs de sistema que registram cada microevento em um servidor, os backups automatizados e os metadados escondidos por trás de cada arquivo constituem um "ruído de fundo" ensurdecedor e volumoso. Esse tráfego invisível é essencial para o funcionamento da rede moderna, mas ocupa espaço real em discos reais, impondo desafios enormes em termos de indexação e recuperação das informações.

A consequência direta dessa hiperprodução é o fenômeno que observamos cada vez mais frequentemente nas empresas com as quais colaboramos: o acúmulo de "Dark Data". Trata-se de informações que são coletadas, processadas e arquivadas, mas que nunca mais serão utilizadas para fins estratégicos ou decisórios. Manter esses dados vivos tem um custo econômico e ambiental elevado. Vemos infraestruturas lentas por terabytes de arquivos duplicados ou obsoletos, que complicam as operações de backup e tornam os sistemas menos reativos. O desafio atual não é mais como armazenar tudo, mas entender o que tem valor e o que pode ser deixado ir.

O impacto dessa aceleração reflete-se também na segurança e na privacidade. Quanto mais dados são criados, mais ampla se torna a superfície de ataque e mais complexa a gestão da conformidade. Cada byte gerado traz consigo uma responsabilidade de tutela. Nos fluxos de trabalho que estruturamos na GoBooksy, a atenção deslocou-se da simples capacidade de acúmulo para a inteligência na gestão do ciclo de vida do dado. Não basta ter espaço infinito na nuvem; é necessária a capacidade de governar a informação, distinguindo o sinal útil do ruído de fundo que entope as autoestradas digitais.

Devemos começar a considerar a produção de dados não como um recurso infinito e gratuito, mas como uma matéria que tem um peso específico. A facilidade com que criamos conteúdos digitais nos desacostumou a refletir sobre seu impacto a longo prazo. Cada vez que um sistema automatizado salva uma versão de um arquivo ou um usuário sincroniza um dispositivo, ativa-se uma cadeia de processos físicos e energéticos complexos. Compreender a escala real desses 2,5 quintilhões de bytes diários é o primeiro passo para passar de uma cultura de acúmulo indiscriminado para uma estratégia de eficiência digital, onde a qualidade da informação prevaleça finalmente sobre sua desmedida quantidade.