Quando os dados pesavam uma tonelada: o legado físico do primeiro Disco Rígido

Uma viagem à materialidade da informática de 1956, quando arquivar 5 Megabytes significava mover uma maquinaria industrial de mais de mil quilogramas. Analisamos como a densidade magnética e a mecânica pesada deram origem ao conceito de acesso aleatório aos dados.

No nosso trabalho diário na GoBooksy, encontramo-nos frequentemente a gerir infraestruturas na nuvem onde terabytes de informação fluem sem ocupar qualquer espaço físico visível, deslocando-se de um continente para outro em milissegundos. Esta desmaterialização tornou-se tão natural que quase esquecemos como, na origem da era digital, o conceito de "dado" estava intrinsecamente ligado a uma massa física imponente e difícil de gerir. Para compreender verdadeiramente a evolução tecnológica que nos levou às atuais memórias de estado sólido, devemos voltar a 1956 e observar de perto um gigante industrial que mudou para sempre a forma de conservar o conhecimento: o IBM 350.

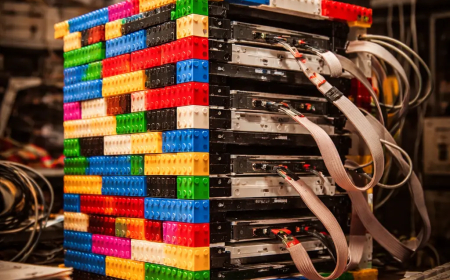

Quando nos perguntam quanto pesava o primeiro disco rígido da história, a resposta deixa muitas vezes incrédulos os interlocutores habituados aos cartões microSD. O primeiro verdadeiro disco rígido comercial, parte integrante do sistema IBM 305 RAMAC (Random Access Method of Accounting and Control), pesava mais de uma tonelada, para ser preciso cerca de 1.000 quilogramas. Não se tratava de um periférico para colocar na secretária, mas de um armário metálico imponente, com um metro e meio de largura e quase um metro e oitenta de altura, que exigia empilhadores e pavimentos reforçados para ser instalado. A logística por trás da entrega destes primeiros sistemas era um feito de engenharia por si só, tanto que muitas vezes era necessário desmontar janelas ou utilizar aviões de carga específicos para o transporte até às empresas que podiam pagar o aluguer mensal, equivalente na época ao preço de vários automóveis.

A razão de tal corpulência residia na tecnologia mecânica necessária para garantir aquilo que hoje tomamos por garantido: o acesso aleatório aos dados. Antes deste monstro sagrado, o arquivamento ocorria principalmente em fitas magnéticas ou cartões perfurados, que obrigavam a uma leitura sequencial e lenta. O IBM 350 mudou as regras do jogo introduzindo uma pilha vertical de cinquenta discos magnéticos de alumínio, cada um com um diâmetro de 24 polegadas, cerca de 61 centímetros. Estes discos, revestidos com uma tinta magnética de óxido de ferro, giravam a 1.200 rotações por minuto num único eixo motor. Imaginar cinquenta "pizzas" metálicas gigantes a girar vertiginosamente ajuda a compreender porque é que toda a estrutura devia ser tão maciça e estável: as vibrações deviam ser reduzidas ao mínimo absoluto para permitir que as cabeças de leitura operassem sem destruir a superfície magnética.

O aspeto talvez mais chocante, se visto com os olhos de hoje, é a relação entre este peso titânico e a capacidade de armazenamento efetiva. Aquela tonelada de metal, cabos, motores e circuitos de válvulas era capaz de memorizar apenas 5 Megabytes de dados. Para dar uma ideia em termos modernos, toda a maquinaria não teria sido suficiente para conter uma única fotografia tirada com um smartphone de gama média ou um ficheiro MP3 de alta qualidade. Na época, no entanto, a possibilidade de arquivar cerca de cinco milhões de caracteres alfanuméricos e de poder aceder aos mesmos em menos de um segundo representava uma revolução sem precedentes para a contabilidade empresarial e a gestão de inventários em tempo real.

Na GoBooksy, refletimos frequentemente sobre como a densidade de área, ou seja, a quantidade de bits que podem ser compactados numa polegada quadrada, é o verdadeiro parâmetro que guiou a evolução informática. Em 1956, a densidade era de apenas 2.000 bits por polegada quadrada. A cabeça de leitura e escrita era uma obra-prima de mecânica pneumática que utilizava ar comprimido para "flutuar" a uma distância microscópica da superfície do disco, evitando o atrito que teria apagado os dados. Este mecanismo de almofada de ar é o precursor direto da tecnologia que, embora refinada ao extremo, encontramos ainda nos modernos discos rígidos mecânicos presentes nos centros de dados.

Os desafios que os engenheiros de meados do século XX enfrentavam não eram assim tão diferentes daqueles que gerimos hoje na conceção de arquiteturas de servidores, embora a escala tenha mudado drasticamente. O calor gerado pelos motores e pelas válvulas do IBM 350 exigia sistemas de arrefecimento dedicados, tal como as modernas quintas de servidores necessitam de climatização avançada. A diferença substancial é que hoje concentramos petabytes em poucos racks, enquanto na altura um centro de cálculo inteiro tinha menos memória do que a cache do processador de um computador portátil económico.

Repassar a história deste gigante de uma tonelada serve-nos para manter a perspetiva correta sobre o valor da otimização. De cada vez que trabalhamos no código para poupar alguns kilobytes ou otimizamos uma imagem para a web, estamos a honrar um caminho iniciado quando cada byte individual tinha um custo físico e económico exorbitante. O primeiro disco rígido ensina-nos que a inovação não é apenas miniaturização, mas é sobretudo a capacidade de tornar acessível e gerível o que antes era lento e sequencial. O peso do passado foi o alicerce necessário para a leveza do presente digital.